Accumu Vol.3

コンピュータ・ハードウェア技術の発展

京都大学名誉教授・(社)情報処理学会会長・龍谷大学教授・京都コンピュータ学院講師 萩原 宏

京都大学助教授 柴山 潔

コンピュータの誕生

ENIAC

第2次大戦中軍事目的でアナログ・コンピュータの開発が進み,また,リレーを使ったディジタル・コンピュータも作られた。戦後になって真空管を使った最初のディジタル・コンピュータENIACが完成した。実に真空管1万8千本以上を使った大規模なものであった。その後,フォン・ノイマン等の提案によるプログラム内蔵方式を採用したコンピュータEDSACが1949年に完成し,引続いて各所でこの方式のコンピュータが動き始めた。こうして,その偉力が認められると各メーカーは競って製品化するようになり,当時の中型,大型コンピュータの名機として名が残るIBM650やIBM704などが生れた。これらはすべて主要素子としては真空管が使われていた。この時代をコンピュータの第1世代と言っている。

やがて1940年代末に生れたトランジスタが成長し,コンピュータの素子として使用できるようになると,トランジスタやダイオードの半導体素子を使ってコンピュータが作られるようになった。これらの半導体素子は真空管に比べて小型で,消費電力も少なく,また寿命も長いなど数々の利点があるため,瞬く間に真空管に取って代ってトランジスタ・コンピュータの時代になった。コンピュータの第2世代である。第1世代のコンピュータは安定度も良くなく信頼性も低かったため,応用面は限られていたが,第2世代になると信頼性も高くなり,広い分野で使用されるようになった。オンライン・リアルタイムの応用もはじまり,また,1台のコンピュータを複数の人が同時に使うタイム・シェアリング・システム(TSS)も開発された。

コンピュータ技術の発展

IC(集積回路)

(京都コンピュータ学院所蔵)

1960年代になるとトランジスタなどの素子を個別部品として使うのではなく,あるまとまった機能をもった回路に作り上げたいわゆる集積回路(IC)の技術が発展してきた。コンピュータの製作にも早速このICが採用されるようになって,コンピュータの世代としても第3世代を迎えることになる。ICを採用することによって,コンピュータの信頼性は飛躍的に向上し,複雑な大規模なシステムを構成することが可能になった。

また,この世代になると,小型から大型までのコンピュータを系列化し,同じ系列では命令体系を共通にして,系列システム間でのプログラムの互換性を保つ方法がとられるようになった。この系列化に大きく貢献したのはマイクロプログラミング技術である。この命令体系を共通にしてプログラムの互換性を保つという考え方はソフトウェアの資産を引継ぐことができるという大きな利点があるため,現在でも広く採用されており,メインフレームでは基本的な命令体系としては1960年代のものが用いられている。

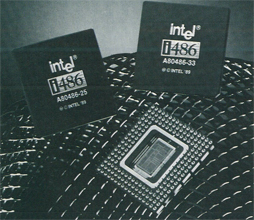

マイクロプロセッサの出現

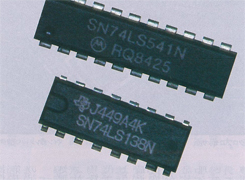

マイクロプロセッサ

(インテルジャパン提供)

半導体技術の進歩により集積回路の集積度は年々大きくなり,大規模集積回路(LSI)と呼ばれるようなものになり,1970年代になると小規模ながら一つの半導体チップの上にコンピュータの処理ユニットを組み立てることができるようになり,いわゆるマイクロプロセッサが誕生した。この技術は年々進歩し,集積度の増大と共に,取扱う情報の単位も4ビットから8ビット,更に16ビットと増大し,1980年代後半には32ビットの処理装置が出現した。これらのマイクロプロセッサでは一つの半導体チップの上に数十万個から百万個を越えるトランジスタを集積しており,超大規模集積回路(VLSI)と呼ばれている。こうして集積回路の集積度の向上により一つのチップの上に処理装置を組み上げるようになり,コンピュータも第4世代になった。

ワークステーション

(キヤノン(株)ネクスト推進センター提供)

16ビットのマイクロプロセッサが出現すると,パーソナル・コンピュータやワーク・ステーションと呼ばれる個人が専有して使用できるコンピュータが生れてきた。量産化され低価格化すると共に,広く普及するようになった。32ビットのマイクロプロセッサの出現に伴って,パーソナル・コンピュータやワーク・ステーションは高性能化し,更に汎用コンピュータにも用いられるようになっている。

第5世代コンピュータ

数年前より第5世代コンピュータという言葉が広く使われているが,これは前節までに述べたコンピュータ技術史の区切りとしての第4世代コンピュータに続く第5世代ではなく,我が国の通産省が1982年から1991年の10ヵ年計画で組織した第5世代コンピュータ開発プロジェクトにより研究開発が進められているコンピュータを指すことが多い。この通産省のプロジェクトを進めるため,新世代コンピュータ技術開発機構(ICOT)という研究組織が作られ,学界,業界の協力の下に第5世代コンピュータの研究開発が進められている。このコンピュータの特徴としては,数百台規模のプロセッサを同時に稼働させる並列処理方式を採用し,また論理プログラミングと呼ぶ新しいプログラミング方式を採用して,科学技術計算や事務処理ではなく,記号処理や人工知能(AI)という新しい応用を目的としていることである。これらの特徴は,従来のコンピュータとは異なる斬新なハードウェア,ソフトウェアの技術の開拓を目指しているといえる。

このプロジェクトの発足を契機に従来のコンピュータ応用の柱であった科学技術計算や事務処理に対抗する形で,記号処理,AIおよび知識処理が新しいコンピュータの応用分野として全世界の注目を集めることとなり,各所でAIや知識処理に向いたコンピュータの研究開発が盛んになってきた。これらの新しいコンピュータを特徴付けるものは,第4世代までの世代を特徴付けた真空管やトランジスタ,集積回路などのハードウェア素子技術とは異なり,推論,連想,学習,エキスパート・システム,問題解決,知識ベース管理,知的プログラミングなどを核とする応用技術である。

現在のAIでは,人間が行う推論や学習および知識の管理をコンピュータが記号を用いて代行できるように,それらの処理過程をモデル化する方法論が主流になっている。すなわちAIにおける処理では,数値データよりも記号データに対する操作が中心となる。またAIにおける記号データ操作では文字列処理などのように単独の記号を対象とするのではなく,記号間の関係を処理対象とするのが特徴的であり,処理対象として,文字列,画像,図形などの一次情報よりもむしろそれらを記号化して関連付け,知識として抽出する点で,AIが必要とする処理機能は記号処理の基本操作の大半を含んでいるといえる。また,知識処理などの最近のAI応用では記号操作が主となり,最近の記号処理,すなわち第5世代コンピュータの主な適用分野としての記号処理はAIそのものといってもよい。

一般的に,AIの応用プログラムを高速に処理する専用コンピュータをAIマシンと呼ぶが,第5世代コンピュータの適用分野が記号処理すなわちAIであることから,第5世代コンピュータはAIマシンであるとも言えよう。また,記号処理応用分野においても,最近,問題を複数個のプロセッサによって分担協調して処理する並列マシンの研究開発が盛んになっている。特に,この並列マシンを記号処理やAI向きに専用化した並列記号処理システムや並列AIマシンが第5世代コンピュータの主流をなしている。

超並列コンピュータ

コンピュータでの処理を高速化する方法としては,素子の高速化とハードウェアの構成方式によるものとに大別される。素子の高速化は半導体技術と回路方式の発展によって著しい進歩を遂げ,新しい素子の出現をみない限り限度に近づいている。構成方式の工夫としてはパイプライン処理と並列処理が考えられるが,パイプライン方式も限界が見えており,残された方法として並列処理が現在最も注目を集めている。

並列処理コンピュータとしては,古くて有名なものは1965年に始まったILLIACⅣのプロジェクトであろう。当初このシステムは64個の処理装置を格子状に結合したアレイに対して一つの制御装置を置いたものを4個組合せてシステムを構成する計画であった。しかし,最終的には64個の処理装置のアレイ1個だけに縮小されて,1973年に完成し,ARPAのネットワークに組入れて活用された。

その後,並列コンピュータは様々なものが開発された。それらの主なものは応用目的のはっきりした専用コンピュータが多い。すなわち,画像処理,図形処理,信号処理,論理設計,人工知能などの各分野の専用機である。これらの応用分野では高速処理に対するきびしい要求があるため,専用コンピュータとして開発が進められたのである。

これに対して,科学技術計算の分野では,演算パイプライン方式のスーパーコンピュータが開発されて,現在のところこれが主流になっている。その理由としては単純なハードウェア構成で,わかり易い一次元処理であり,問題を一次元のベクトル演算に定式化できればプログラムにより高速処理ができる汎用性を有していること,また,高度のベクトル化コンパイラが開発されて,FORTRANなどのプログラムを比較的容易にベクトル化できるので,ユーザにとって使い易いシステムになっていることなどが上げられる。

しかし,汎用超大型コンピュータの高速化の限界が認められ,また,スーパーコンピュータの性能の限界と適用分野が限られていることなどのため,並列処理コンピュータに大きな期待が寄せられるようになった。これに対して処理装置数百台程度の汎用並列コンピュータの試作が進められ,一部では製品化もはかられている。しかし,マイクロプロセッサ数百台規模のマルチプロセッサ・システムでは,汎用超大型機あるいはスーパーコンピュータにくらべて画期的な性能向上を望むことは出来ず,数千台から数万台規模の超並列マルチプロセッサ・システムに対して大きな期待が寄せられており,超並列コンピュータの開発が急がれている。これに対しては,ハードウェア構成上の問題だけでなく,並列プログラミング言語をはじめとするさまざまなソフトウェア上の問題を解決しなければならない。

ニューロコンピュータ

脳の構造を模倣して,その神経回路網を電気的にあるいは光素子などによって構成して情報処理を行わせようというのがニューロコンピュータである。

ニューロコンピュータの研究は1950年代から60年代にかけてかなり活発に進められ,パーセプトロンなどの提唱もあったが,パーセプトロンの限界説などが出され,また,ノイマン型コンピュータの隆盛などによりニューロコンピュータの研究は下火になった。

しかし,1980年代になると再びニューロコンピュータが脚光をあびるようになった。それはノイマン型コンピュータの性能の限界が見えはじめ,AIの分野での情報処理が逐次的な情報処理と適合しないのではないかという疑問が生じたためである。現在の汎用計算機やその延長上の並列処理では対応できない問題があり,新しい計算モデルが求められるようになった。そして,1980年代半ばにさまざまなニューロモデルが提唱され,新しいアルゴリズムが提唱された。このようにニューロコンピュータの新しい応用分野が開かれ,またその有効性も示されたことによってニューロコンピュータが再び脚光を浴びることになったのである。

ニューロコンピュータにはパターン認識機械のようにユーザが教師となって入力パターンと出力パターンの対応関係を学習させ,システムはノード結合の重みの変更などの形で学習成果を蓄積し自己組織化する学習機械としての応用と,解こうとする問題をエネルギー関数最小化の形に定式化し,システムはエネルギーを最小化するように動作して平衡点が一つの解を与える最適化機械としての応用が考えられている。

おわりに

コンピュータは数値計算を高速に行うことを目的に開発され,現在でも数値計算に広く使用されている。しかし,ノイマン型のプログラム内蔵方式のコンピュータは柔軟性があるため,現在ではコンピュータの役割は数値計算だけでなく,むしろそれ以外の応用の方がはるかに多い。

一方前述のように使用目的に応じた各種の専用コンピュータが開発されており,第5世代コンピュータのプロジェクトでは人工知能を主な対象として開発されているし,ニューロコンピュータはパターン認識に適している。

このようにみるとコンピュータはその用途に応じて処理の仕方や構造が異なったものになるべきだという考え方が出てくる。このような見方をすれば,現在はコンピュータの概念が大きく変りつつある時代であるともいえよう。動作原理も電気的なものだけでなく,もっと広い自然現象が応用可能で,たとえば,光コンピュータ,バイオコンピュータなども研究対象として考えられている。

コンピュータの分野ではこのようなさまざまな考え方が交錯して,数々の新しい研究が活発に進められており,将来の発展が楽しみである。