Accumu Vol.11

ランドマークベースの音声認識において最適な指標を求める方法

イリノイ大学工学部助教授 Mark Hasegawa‐Johnson

本論文は相互情報量を用いて,ランドマークに対する音声情報量の時間‐周波数空間における分布を推定するものである。TIMITの音声データを解析して,調和終了ランドマーク,調和発生ランドマーク,話し方変化ランドマーク,母音・半母音ピボットランドマークの位置を推定する。メル尺度(人間の聴覚の特性にあわせて低周波部分は細かく,高周波部分は大まかに調べるための尺度の一つ)において,各ランドマークを中心に250msの範囲でスペルトルを計算して,エネルギーの対数を取ったものを線形に量子化する。ランドマークとの関係の上で,それぞれの音に対して特徴(25種類)があるかないかを0か1でつける。最後に,特徴の種類とスペクトルのエネルギー値の一致回数を数え,確率を計算して,それぞれの特徴についての『infogram』と呼ばれるものを求める。これは,特徴の種類と時間‐周波数空間の各点におけるスペクトル値との相互情報量を与える指標になっている。

1 イントロダクション

音の情報というのは,顕著なランドマーク(調和音の発生と終了,半母音の最大緊縮,母音の定常状態)の周辺に集中しているということが音響実験によって明らかになっている[5]。Stevens等は知識ベースでランドマークと音声特徴を位置合わせする手法を提案しており[7],またLiuは約91%の精度でランドマークを検出する知識ベースのシステムを作ることに成功した[3]。Halberstadtは領域ベースの手法よりもランドマークベースの統計的な手法の方が単語認識においてより高い精度が出ることを示している。[2,1]。

本論文はStevens等の手法にYang,van Vuuren,Hermansky[9]の相互情報量を利用した手法を取り入れたもので,TIMITデータベース(LinguisticData Consortium, 1990)から1491個の例文を使用した。本論文ではランドマークでの特徴の種類と,ランドマークの周りでのメル尺度スペクトルの値(振幅)X(t,f)に関して相互情報量を計算する。相互情報量は基本的な情報理論によるもので,ここでの得られた指標というのは,(ランドマークに対応した)スペクトルの持つ特徴の種類に関する情報量の分布を表している。この分布を本論文では『infogram』と呼ぶことにする。

2 計算手法

infogramは特徴の種類と時間‐周波数空間のスペクトルの値との相互情報量を表すものである。この相互情報量を計算するためには,会話データベース中の数千にのぼる箇所からランドマークとそこでの特徴の種類を取り出してこないといけない。2.1章では,TIMITデータベース中にある音声データを利用して,ランドマークの位置とそこでの特徴の種類を推定する手法を述べる。

2.1 顕著な特徴

本論文では4種類のランドマークを考える。調和音終了ランドマーク,調和音発生ランドマーク,母音・半母音ピボットランドマーク,そして話し方変化ランドマークである。調和音終了ランドマークでは母音・半母音の終了もしくは閉鎖音や鼻声子音への流音が起こる。話し方変化ランドマークは,共鳴音,継続音,不快音などの特徴に関してことなる二つの調和音間の移り変わる部分に起こる。半母音,弾音ピボットランドマークは半母音,流音,もしくは弾音子音の最大緊縮の位置に来る。そして,母音ピボットランドマークは母音の中心に来る。

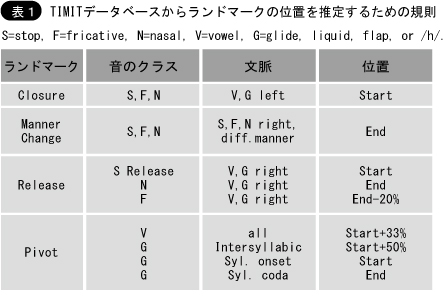

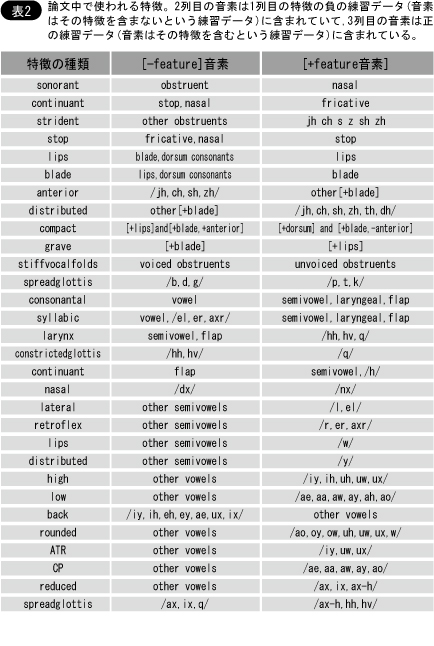

終了ランドマーク,発生ランドマーク,話し方変化ランドマークの位置はTIMITデータベースの中に書かれている[10]。一方,ピボットランドマークの位置は記載されていないため,推定の必要がある。しかし,この研究ではTIMIT TRAINデータベース中のランドマークの位置は全て,表1に挙げてある規則に従って推定した。表によりTIMITデータベースの音声領域は,それぞれ対応する1行目のランドマークになる。同時にランドマークの位置も特定される。(表2)。

Stevens等によって提案された非線形特徴幾何[7]を利用して各音素に音の特徴ラベルを割り当て,非線形の音韻論の理論によって,特徴に階層構造を定義する。特徴dは,「そこにある」(d=+1),「そこにない」(d=1),「特定していない」,のどれかの状態を取る。特徴が「特定していない」という状態は,その親の特徴によって「意味が無い」もしくは「顕著でない」と決定された場合のみ起こる。ここで使われている特徴階層では,根にあたる特徴[consonantal]は常に特定されているとする。全ての[+consonantal]と特定された音は,話し方の特徴([sonorant(鳴音)]と[continuant(継続音)]と発音の仕方の特徴([lips(唇音)]と[blade(舌端音)]と[body]を持つとする。他の特徴は,その話し方と発音の仕方によって指定されたりされなかったりする。このStevens等によって提案された特徴の集合に加えて,音素を部分集合にどう分割出来るかを確かめるために,たくさんの冗長な特徴も調べた。例えば,特徴[grave(抑音)]と[compact]は,調音上の分類よりもむしろ音響学をベースとして発音の仕方に関する特徴だとした。

2.2 相互情報量の計算法

それぞれのランドマークで,51フレーム,30帯域で23レベルに量子化されたメル尺度スペクトルを求める。この解析には3種類のウィンドウの長さ(6ms, 12ms, 20ms)を用いて,ウィンドウ自体は5msシフトさせて計算する。それぞれ1024点によるFFTを使ってスペクトル値を計算した。これらのスペクトル値の結果は中心の周波数と帯域幅が一様に,0から2840メル(8kHz)までのメル尺度上で分布しているHanning-shapedフィルターを使って統合した。それぞれTIMITデータベース中の30個のサンプルスペクトルに対して最小値と最大値を取ってきて,対数を取って間を均等に23レベルに量子化する。

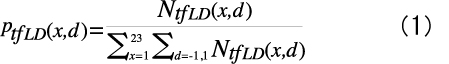

特徴の種類とこの量子化したスペクトル値が一致している回数を1491個の例文に関して数えてみた。具体的に書くと,スペクトル値x=X(t,f)と特徴の種類d∈{1,1}が一致しているかどうかを,それぞれ時間t,周波数f,ランドマークの種類L,そして特徴の種類Dに関して数え挙げてNtfLD(x,d)とした。一致の確率は以下の式で推定される。

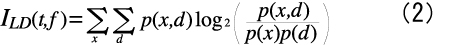

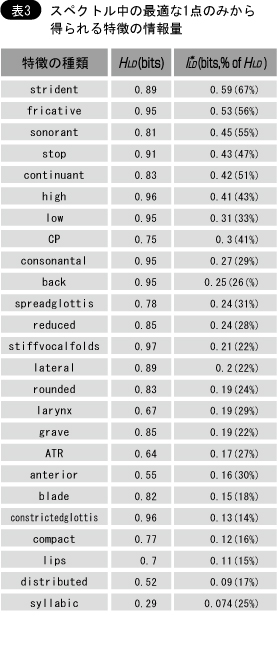

特徴の種類Dとスペクトルの値との相互情報量は対数確率を足し合わせていきinfogramILD(t,f)として次のように求められる。

ただし,確率の添字は便宜上省略した。

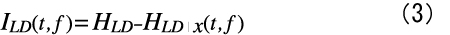

ILD(t,f)は特徴のエントロピーHLDと,スペクトル値X(t,f)が分かっている時の条件付エントロピーの差でもあるので,以下のようにも書ける。

ただし

HLDとHLD|x(t,f)は共に非負であり,HLD|x(t,f)?HLDである。特定されている特徴の値は2種類しか取り得る値がない(d=1 と d=1),よって上の等式から次式が導かれる。

スペクトル値が特徴の種類と独立な時はILD(t,f)=0となり,スペクトル値が完全に特徴の種類と従属な場合はILD(t,f)=HLDとなる。特徴dが1にも-1にも同確率でなる場合にHLD=1が成り立つ。

3 実行結果

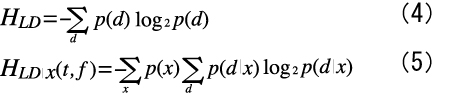

1点でのスペクトル値から特徴の種類に関して分かる情報の最大量は

である。

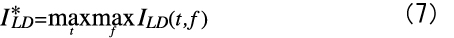

表3は,それぞれの特徴Dに対して,20msのウィンドウ幅で計算した場合のI*LDを,ランドマーク全4種類に関して平均したものである。I*LDはその情報量を表すビット長と特徴エントロピーHLDからの割合で表示してある。ランドマークの種類と特徴の種類全てに関してI*LDの平均を取った結果は,0.240ビット,30.5%となった。12msのウィンドウ幅を使った場合のこの数値は0.236ビット,30.0%で,6msのウィンドウ幅の場合は0.224ビット28.4%であった。よって,この論文中ではinfogramの計算には20msのウィンドウ幅を用いることにした。

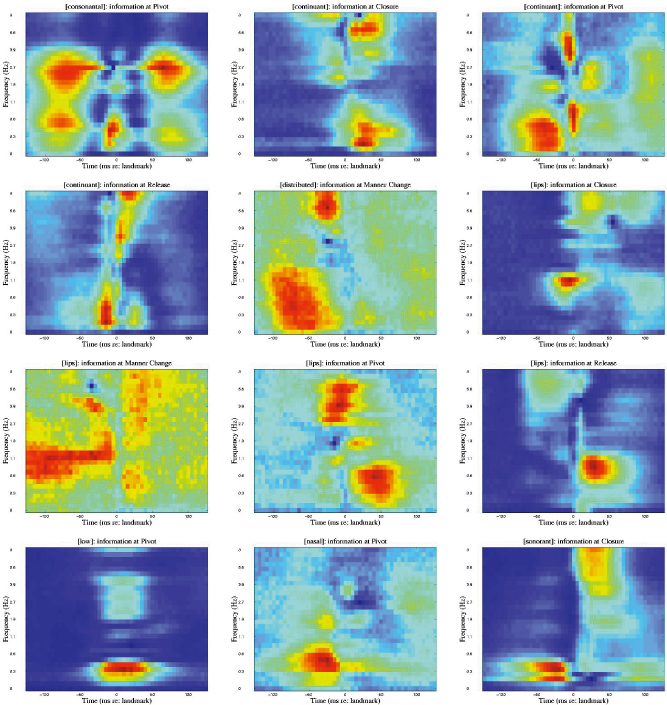

等式(2)に従って計算したinfogramの結果を図に示す。infogramは「ランドマークの種類:特徴の種類」で表されている。ただし,C,R,M,Pはそれぞれ終了(closure),発生(release),話し方変化(manner change),ピボット(pivot)のランドマークである。黒が情報0を意味していて,白いほどI*LDに近いことを示している。

4 考察

図中のinfogramは音声学の理論によって予測できる情報量の分布を表している。特徴[sonorant]と[stiffvocalfolds]の情報は終了ランドマークと発生ランドマークでは600Hz以下に集中している。また,特徴[continuant]と[strident]の情報は2500Hz以上に集中している。母音に関する特徴の情報は-50msと+50msの間のフォルマント(音声波のスペクトル分析における特定周波数の集中帯)にあることが分かる。特徴[reduced]はその例外となっていて情報が集中せず拡散してしまっているが,これはそのタイミングが大切な情報を持っていると考えられる。ピボットランドマークにおける特徴[continuant]も同様にタイミングが情報を持っていると思われる。発音の仕方の特徴[lips]などはもっと複雑に見えるが,これらには音声認識で伝統的な手がかりである次の三つ,摩擦スペクトル,フォルマントの発生,破裂スペクトルに有用な情報があるようだ。

infogramILD(t,f)は特徴の種類とスペクトル値の間の相互情報量を,スペクトル内部同士の関係を無視して計算したものであるが,音声特徴の情報というのは異なる時間と異なる周波数でのスペクトル値の関係の中にあると主張する音声認識の研究は沢山ある[6,8]。しかし,もし情報がそのような関係の中にのみあるのだとしたら,p(x,d)だけからなるinfogramは認識の役には全く立たないという結果を示すことになる。この意味ではinfogramは,スペクトルの相対的な手がかり無しで果たして情報が得られるのか,また得られるならばどれくらいなのかを表す良い指標になっていると考えられる。

実際はどうかというと,表3の結果から分かるのは,[strident]や[continuant]や[sonorant]のような話し方に関する特徴は,時間‐周波数空間から選んだ1点におけるスペクトル値のみからでも認識をすることが出来るが,[lips]や[blade]や[anterior]や[distributed]のような発音の仕方に関係する特徴は,スペクトル内の相対的な情報を使わないと認識するのは難しいだろうということである。これは,音声にノイズが入ると聴取者の発音の仕方に関係した特徴を認識する能力は,話し方の特徴を認識するそれよりも大きく低下する,としてしまった結果[4]に対する良い説明になっているだろう。それは単に,使用するのがスペクトル内の1点のスペクトル値だけならば,ノイズの影響が強い時に,話し方は識別できても,発音の仕方はできないということを表しているのである。

将来の課題は,スペクトルの情報を1点のみで使った場合に対して,複数の点を含めた相対的なものを使った時に,どれだけ認識に有利になるかを表す指標の開発である。それぞれの特徴に対する時間‐周波数空間中で最も情報量の多い点は3章の結果から求められる。そして,上記の最も情報量の多い点を固定して,この点でのスペクトル値と特徴の種類に対する,他の点でのスペクトル値の結合相互情報量を計算して『結合infogram』を求めることができる。このプロセスを繰り返せば各特徴に対して最適な情報を表現する3点もしくは4点などが分かるのである。

参考文献

[1]Andrew K.Halberstadt. Heterogeneous Acoustic Measurements and Multiple Classifiers for Speech Recognition. PhD thesis,MIT,Cambridge,MA,Nov.1998.

[2]Andrew K.Halberstadt and James R.Glass. Heterogeneous measurements and multiple classifiers for speech recognition.In Proc.ICSLP, Sydney,Australia,Nov.1998.

[3]Sharlene A.Liu.Landmark detection for distinctive feature-based speech recognition. J.Acoust.Soc.Am.,100(5):3417-3430,Nov.1996.

[4]G.A.Miller and P.E.Nicely. Analysis of perceptual confusions among some English consonants. J.Acoust.Soc.Am.,27:338-352,1955.

[5]K.N. Stevens. Evidence for the role of acoustic boundaries in the perception of speech sounds. In Victoria A.Fromkin,editor,Phonetic Linguistics:Essays in Honor of Peter Ladefoged,pages 243-255.Academic Press,Orlando,Florida,1985.

[6]K.N. Stevens.Relational properties as perceptual correlates of Phonetic features. In Proc.Eleventh Int.Conf.Phonetic Sciences, volume 4,pages 352-356,Talinn,Estonia,1987.

[7]K.N. Stevens,S.Y.Manuel,S.Shattuck-Hufnagel,and S.Liu. Implementation of a model for lexical access based on features. In Proc.ICSLP,volume 1,pages 499-502,Banff,Alberta,1992.

[8]Alexander Waibel,Toshiyuki Hanazawa,Geoffrey Hinton,Kiyohiro Shikano,and Kevin J.Lang.Phoneme recognition using time-delay neural networks.Trans. Acoust.Speech Sig.Proc.,37:328-339,1989.

[9]Howard Yang,Sarel van Vuuren,and Hynek Hermansky.Relevancy of time-frequency features for phonetic classification measured by mutual information.In Proc.ICASSP,Phoenix,AZ,1999.

[10]V.W.Zue,S.Seneff,and J.Glass. Speech database development at MIT:TIMIT and beyond.Speech Communication,9:351-356,1990.

関連URL

http://www.ifp.uiuc.edu/speech/recognition/infogram/index.html