Accumu Vol.3

情報科学をめぐって

広島大学名誉教授

元図書館情報大学副学長

福山大学教授

鳴海 元

「情報とは何か」という課題に根本的に答えるのは,哲学の問題かもしれない。「科学」という以上,情報に関するいろいろな現象を,できるだけ精密に分析し,それを総合して,統一的,普遍的に,内部矛盾の無い理論体系を作り上げる方法を見いだすことこそ,「科学」の本来の姿であろう。

ところが,情報に関する現象を科学の対象として,どのように定義するかという問題は,決して容易ではない。しかも,人間にとって情報とは何かを考える場合には,単に自然科学の範囲の現象に限られない。なぜなら,情報という場合,単なるデータの蓄積とか,体系的な知識そのものにとどまらず,或る目的をもった伝達の過程が含まれている。したがって,一般に道具や機械の創作に先立って,広い意味では生命体が環境に適応して生存するための情報の伝達や制御,さらに人間にとっては,情報に対する価値観まで関わってくるからである。このような意味では,情報という現象は,生命の誕生以来の最古の,そして人文,社会科学にもわたる巨大科学の様相を呈していると考えられる。

そこで,情報という抽象的現象を,科学の対象として取り上げ,その方法を提起したのは,ようやく今世紀の半ばであると言えよう。近代科学が,ガリレイ,ニュートンの力学に始まり,これを体系化する方法として解析学(微積分学)という言葉を創り出したことはよく知られている。この場合の物理学の対象は,まさに地球上の物体と天体の運動であり,これらに共通する万有引力の法則の発見を踏まえて,現在古典力学とよばれる典型的な科学の最初の分野が出来上った。一方,情報科学は,このように科学として対象を明確に限定できないし,方法としても,矛盾の無い一貫した新しい言葉を創り出しているわけでもない。しかし,その出発点を与えたのは,ウィーナーの「サイバネティックス」(1948年),動物と機械における制御と通信に関する著作であろう。また,この科学の一つの方法を具体的に提起したのは,シャノンの「通信の理論」(1949年)であり,ブリルアンの「科学と情報理論」(1956年)も見逃すことはできない。

その上,情報現象を,多様な知識の集まりとしての情報そのものと,その情報を処理伝達する手段とに分けて考えることができるとして,前者を「情報体」,後者を「媒体」と呼ぶことがある。そうすれば,情報科学というのは,情報体の具体化と媒体の主な機能を担う,計算機の飛躍的な進歩によってもたらされたと言えよう。

そのために情報科学をコンピュータ・サイエンスと呼んだり,情報処理技術と受け取られていることに注意を払う必要がある。科学と技術とは,本来異なる知的産物である。端的に言えば,科学は,あくまで真理の探究にあり,技術は人間に役に立つと思われる,広い意味での道具の開発にあると言えるかもしれない。この科学の概念を技術と峻別して確立したのは,近代科学そのものにほかならない。19世紀は,いわばこの古典的科学の完成の時代であったとも考えられる。ところが20世紀の科学の特徴は,その対象が,目に見える巨視的(マクロ)な現象から,直接目に見えない微視的(ミクロ)な現象に移ったという事実にとどまらず,量子力学とか相対性理論という新しい論理体系ないし,新しい言葉が創られたのである。それと同時に,科学と技術との関係が,きわめて密接になったことを見逃すことができない。

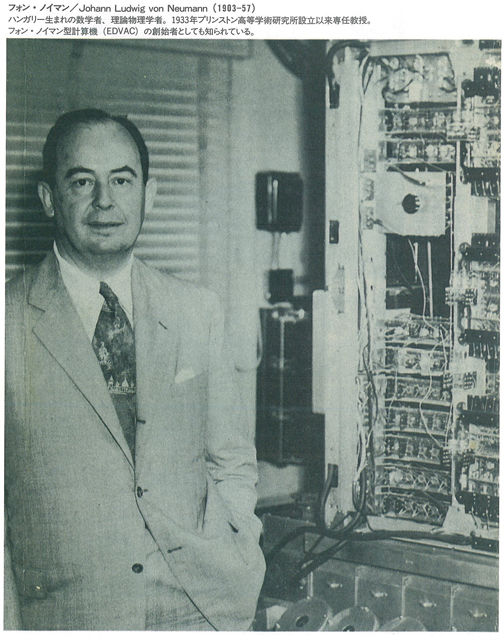

先に述べた情報機器の一つの例として計算機を取り上げてみよう。ソロバンは別として機械的加算器の作成は,当時科学とは別の目的をもって,物理学者であり思想家でもあったパスカル(1)に始まり(1642年),プログラムを内蔵する計算器の着想は,イギリスの数学者バベージ(2)による(1830年)と言われている。そうして今世紀に入って,前に述べた数学者ウィーナーの提案(1940年)に基づいたリレー式計算器(1944年)の開発を経て,実際にプログラムを内蔵する方式の計算機が具体化されたのも,まさに数学者であり,理論物理学者であったフォン・ノイマンの着想によることを忘れてはならない。

一方,第1世代の真空管電子計算機ENIAC(1946年)に始まり,トランジスタから集積回路における記憶素子の半導体化への開発研究が,さきに指摘した,ミクロの科学,量子(固体)物理学の発展と切り離すことのできないことも事実である。 このように,科学と技術は一体化して,社会の変革をもたらし,高度情報化社会と言われる21世紀に向かおうとしているが,まだ半世紀にも満たない歴史をもつ情報科学の急速な発展にもかかわらず,初めにも述べたように,科学としては,理論的構成になお多くの課題を残している。しかし,それだけ将来に夢のある巨大科学であるとも言えよう。けれどもそれと同時に,科学としての限界を自覚しなければならない。科学に限界のあることは,従来とは別の意味で,今世紀に改めて認識できたことである。

言うまでもなく,技術にも,いろいろな意味で現実的な限界のあることは確かである。物理学でも,実際に実験を行なう場合には,かならずその測定には統計的な誤差を伴い,究極的には,決して精確な値を一義的に与えることはできない。これは「実際上」の不確定さで,限りなく小さくすることが可能である。けれども,ミクロの科学では,粒子の位置と運動量とを,同時に精確に与えることは,「原理的」に不可能であるというハイゼンベルク(3)の「不確定性原理」が存在している。これは,どんなに観測の精度を上げても,乗り超えられない限界のあることを示している。また相対性理論では,光速度を超えるような伝搬速度をもつ信号は存在しないという仮定がある。この事実も,情報機器の開発,とくにその小型化に対してさえ,無視することができない限界のあることを示唆している。

このような自然科学の特質は,20世紀の科学に固有なものであると思われる。その上物理学における不確定性原理が提唱された(1927年)のと同じ頃,数学の分野においても,ゲーデルによる「不完全性定理」が(1931年)公表されたことは,まさに画期的なことであった。それは「どんな公理系においても,真であるか偽であるか,どちらの証明も不可能であるという定理が存在する」ということを証明したのである。つまり,数学は一群の公理から,いろいろな定理を矛盾なく証明し尽くす論理体系であるが,その中に矛盾が存在しないことは,前世紀までは,自明の理であると考えられていた。しかし,公理系の相対性の上に,さらに「公理系に矛盾の無いことを,その公理系の中で証明することはできない」という論証は,単に数学基礎論とか数理論理学上の問題にとどまらず,あらゆる科学や,人間の認識にも,きわめて大きな衝撃を与えたのも当然である。

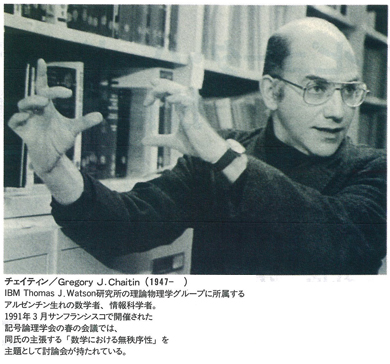

ところが最近,IBMの数学者チェイティンは,アルゴリズムの情報理論に基づいて,数学それ自体の中に,すでに無秩序性が存在することを証明したと言われる。これはまさに注目に値する事実である。かれの根底には,ゲーデルの定理から暗示されたパラドックスがあった。それは「或る文章に使われている文字の数よりも多い数で表現されている整数のうち,最小のものを示せ」という命題である。これを計算機のプログラムに応用(計算機実験)して,或る数のビット数と,それを求めるビット数との間に,矛盾が生じることを指摘したのである。つまり「Nという数よりもはるかに小さいビット数のプログラムでNを算出した結果そのものが,Nより大きいサイズのプログラムでしか計算しえない」ことを証明したと言うのである。しかし,この証明には,17000もの変数を含む(ディオファントス)不定方程式が用いられているようで,これをどのように具体化したかは不明である。なお,数の集合に,本来無秩序性があるのか,それとも決定論的カオスに基因するのかは定かでない。

それにもかかわらず,この論証は情報科学にとって,きわめて重要な問題を提起していることは確かである。と同時に,無秩序性の原理は,すでに物理学において,導入されているが,数学においてもこの事実が内在しているとすれば,数学と物理学に方法論的基礎を置く情報科学に限らず,科学そのものにとって,特筆すべき成果であるに違いない。

科学は人間によって創られたものであるが,科学それ自身によって,その限界を論証しえたことは,20世紀における人類の貴重な遺産の一つであると言えるだろう。

註

(1)パスカル-Blaise Pascal (1623-62) フランスの広い意味での哲学者。数学や物理学で「定理」や「原理」と呼ばれている成果を残し,一方「パンセ」の著作でも有名である。加算器は税務管理者の父の仕事を助けるために製作したと言われている。

(2)バベージ-Charles Babbage (1792-1871) イギリスの数学者,発明家。てこや歯車などの機械仕掛けを用いた計算器を考案し,プログラム記憶方式ではないが,10進50桁の数値を1000個記憶する装置を考えていたが完成には至らなかった。

(3)ハイゼンベルグ-Werner Karl Heisenberg (1901-76)はドイツの理論物理学者。量子力学の建設者の一人。代表的著作の一つである「量子論の物理的原理」(1930)の中に「不確定性原理」が詳述されている。